Настройка robots.txt для WordPress.

Правильно настроенный robots.txt обеспечивает грамотную индексацию нашему сайту, неправильный же может совсем убрать его из обзора поисковиков) Поэтому обязательно нужно уделить этому вопросу должное внимание.

Если вы заметили, что в индексе поисковиков откуда-то обнаруживаются дубликаты ваших постов, или какие-то непонятные страницы, то проблема наверняка именно в robots.txt.

Нередко замечал даже у довольно крупных и раскрученных сайтов и блогов ошибки в данном файлике.

Но прежде чем создавать robots.txt некоторые из вас(новички) могут задаться вопросом – а что собственно это за зверь такой?

Что такое robots.txt и зачем он нужен?

Это обычный txt-файлик, который расположен в корневом каталоге ваше сайта. Главным образом robots.txt нужен для того, что бы ограничивать доступ поисковиков к некоторым страницам вашего сайта, т.е. что бы они не индексировались.

Вы скажите, зачем же мне что-то прятать от поисковых роботов, я хочу, что бы мой сайт был в поиске! Однако уверяю вас, практически на любом сайте есть что укрыть от всевидящего ока, особенно сайты на CMS WordPress 🙂

В первую очередь это служебные разделы вашего сайта и дубликаты страниц (которых Worpress плодит очень много)

Ну согласитесь, зачем поисковику нужно копаться в админской зоне, или скажем в папке с установленными плагинами. Так же нужно обязательно прятать повторяющиеся страницы.

Откуда берутся дубликаты страниц в Worpress? Да отовсюду 🙂

Это архивы страниц по меткам, это архивы по дате, архивы по авторам, по категориям (рубрикам) В результате, если не закрыть их от индексации поисковиков, то в поисковой выдаче могут появиться много вариантов одних и тех же страниц.

Чем это может мне навредить, спросите вы? Ну, во-первых, проиндексировать 50 страниц, или 300 страниц , есть разница. Вы значительно ускорите индексацию своего сайта, убрав все лишнее и оставив только самое нужное.

Кроме того, робот может проиндексировать ненужные страницы, а до нужных так и не добраться, или же добраться но очень нескоро.

Так же у вас могут быть личные страницы, которые вы не хотите выставлять на всеобщее обозрение.

Стоит задуматься и о том, что бы скрывать и комментарии от индексации, если их очень много и они не особо модерируются.

Помимо прочего в robots.txt указывается главное зеркало вашего сайта. URL сайта может выглядеть как www.sait.ru или просто sait.ru и для поисковиков это два разных сайта.

Что бы узнать какое у вашего сайта главное зеркало наберите его в браузере с www, и если URL измениться и www исчезнет в адресной строке, то ваше главное зеркало sait.ru Если же останется www.sait.ru то это и есть главное зеркало. Разумеется вместо sait.ru подставляем адрес своего сайта.

Еще в нем указывается местоположение карты сайта для поисковиков sitemap.xml. Что это такое и как ее создавать я писал в предыдущем уроке , если вы не делали sitemap, то обязательно сделайте!

Как создать правильный robots.txt для WordPress.

Вот так выглядит мой robots.txt на данный момент:

[sourcecode language=»plain»]

User-agent: *

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: */comments

Disallow: /page

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /category

Disallow: /wp-login.php

Disallow: /tag

User-agent: Yandex

Disallow: /cgi-bin

Disallow: /wp-admin

Disallow: /wp-includes

Disallow: /wp-content/plugins

Disallow: /wp-content/cache

Disallow: /wp-content/themes

Disallow: */comments

Disallow: /page

Disallow: /trackback

Disallow: */trackback

Disallow: */*/trackback

Disallow: */*/feed/*/

Disallow: */feed

Disallow: /*?*

Disallow: /category

Disallow: /wp-login.php

Disallow: /tag

Host: ruskweb.ru

Sitemap: https://ruskweb.ru/sitemap.xml

Sitemap: https://ruskweb.ru/sitemap.xml.gz

[/sourcecode]

Можете скопировать в свой файл robots.txt, практически все настройки стандартные, убирают дубликаты страниц и закрывают админскую зону, в которую не нужно совать нос) Единственное что вы можете открыть комментарии если хотите, удалив строчки 8 и 26 Disallow: */comments.

Если же у вас вообще нет robots.txt то создайте его в блокноте и поместите в корень вашего сайта.

Тут читаем что такое корень сайта и как копировать файлы на ваш сайт.

Важно! Не забудьте изменить адрес сайта в последних трех строчках на ваш собственный.

И немного о том что мы там прописали.

User-agent: определяет к какому поисковику относятся правила.

В строке Disallow: мы закрываем доступ поисковикам к разделам сайта.

В строке Host: указываем главное зеркало своего сайта.

В строке Sitemap: мы указываем местоположение карты сайта sitemap.xml

Проверить работу файла можно в инструментах для Вебмастера Яндекс или Google.

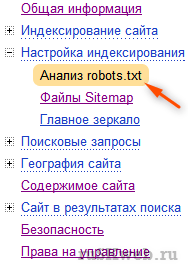

В Яндексе нужный нам раздел находится в Настройка индексирования — Анализ robots.txt

Загружаем robots.txt с сайта, и можем проверять работу.

Возле списка URL жмем кнопку добавить и вписываем все адреса с сайта, доступ к которым хотим проверить. К примеру проверим доступны ли записи(а они должны быть доступны) и проверим закрыты ли метки. Добавляем адреса, и жмем кнопку Проверить.

Как видите в результатах проверки, все работает как нужно, посты индексируются как и положено, а доступ к архивам запрещен. Причем там же указывается каким правилом.

По аналогии, если вы пользуетесь Гугловскими инструментами, там все тоже самое делаем.

Ну вот собственно и все, мы сделали большое дело для нашего нового блога таким маленьким тестовым файликом 🙂

Если есть какие-то вопросы, не стесняйтесь, задавайте в комментариях, постраюсь вам помочь)

Комментариев: 33

Добрый день!

Очень много пишут о том, зачем нужен robots.txt, как его подогнать под свой сайт и все… А где же главное — КАК поместить его в корень сайта? Я очень даже новичок и мне эта операция совершенна непонятна.

Здравствуйте Светлана.

Спасибо за замечание, сейчас дополню статью. Иногда забываю что блог читают в первую очередь новички)

Корень сайта это главная папка предоставляемая провайдером, в которой и располагаются файлы вашего сайта. У разных хостингов она может называться по разному, у меня, к примеру, это public_html/ у некоторых это может быть www/. Туда и нужно копировать robots.txt

Подробней вы можете прочитать в этом уроке https://ruskweb.ru/osnovyi/chto-takoe-koren-sayta-nastroyka-ftp-klienta.html

Привет.

Еще желательно указать главное зеркало сайта в панели Вебмастера Яндекс

Хотя, директива host тоже самое делает

Здравствуйте Дмитрий, только о вас вспоминали недавно =)

Да, там много чего интересного. У меня проблем с Яндекс.вебмастером не было, он отлично с host зеркало взял. А вот с гуглом пришлось повозиться

По какому поводу вспоминали? )

гадости всякие говорили 😀

И такое бывает)

Ну если серьезно то вас привели в пример как человека достигшего успеха без SEO =)

https://ruskweb.ru/internet-zarabotok/zarabotok-v-internete-konkurs-s-prizovyim-fondom-1111.html#comment-145

Да я давно уже не заморачиваюсь по этому поводу)

Каждый день баню всяких придурков. А раньше переживал. Думал, что не так : )

Письмо приглашение дошло?

нене, мы вас наоборот нахваливали, сео и правда не сегодня так завтра может загнуться, или изменится до неузнаваемости после смены алгоритмов)

да пришло, спасибо. как раз ответ пишу)

Что-то вы уж слишком плохого мнения о seo. Загнуться оно не сможет, еще очень долгое время. Изменится — да, но и это произойдет не скоро. Изменения возможны не столь масштабные, поэтому делать надо СДЛ и все будет норм 🙂

ну я имел ввиду загнется в том виде, в котором оно есть сейчас — вроде продвижения покупными ссылками и т.д.

как раньше загнулось продвижение каталогами и спамом ключей.

разумеется само сео никуда не денется)

Сергей! У меня роботс другой, от школы Старт Ап. Заменять на Ваш?Что-то боюсь. Я с тем роботсом достаточно давно. А если надо заменить, тогда как :удалить прежний и поставить этот?

Тамара тут все индивидуально конечно, приведенный мной robots вполне стандартный и ничего страшного наделать не должен) закрывает метки и рубрики от индексации.

покажите мне ваш роботс, я гляну и скажу уже как лучше. можете на почту скинуть

Согласен, от вашего шаблона многое зависит 🙂 Хотя в большинстве случаев они похожи, поэтому я думаю, что можете оставить свой robots. Ведь в Start up не вафли сидят 🙂

Хорошая статья….будем заниматься)))

Если будешь экспериментировать с настройками, то советую проверять в инструментах вебмастера работоспособность роботса)

Загоняешь в форму пару ссылок которые должны быть открытыми и пару ссылок которые не должны индексироваться и проверяй

ок

Вот у меня возник вопрос оставлять ли открытыми комментарии в роботс? Если комментарии осмысленные и по делу, а еще и с ключевыми словами — они, я думаю, только помогут оптимизировать статью. Тем более робот будет видеть, что идет живое обсуждение. Даже где-то читала, что комментами можно повышать рейтинг своей статьи в поисковой выдаче. Тем более иногда могут люди из ПС зайти по фразам, которые находятся в комментах. А какие отрицательные моменты не закрытых комментов?

Кристина тут сложно сказать… вообще мне кажется комментарии и так и так будут читаться, потому что они на одной странице со статьей, а в роботс просто закрываются якорные ссылки на комменты. У меня раньше были закрыты, сейчас открыл. Если комменты по теме, без флуда и спама, то думаю только на пользу идут. А все лишнее можно просто удалять)

Привет. Спасибо за полезную ин-фу. Такой вопрос, а что конкретно закрывает такая конструкция:

Disallow: /category/*/*

Чем она будет отличаться от такой:

Disallow: /category

Приветствую Олег.

На страницах категорий существует пагинация, т.е. разбиение на несколько страниц если постов слишком много с навигацией типа /category/page/2/ 3, 4, 5 и т.д.

Вот их то мы и закрываем за компанию. По сути Disallow: /category тоже закрывает пагинацию и саму страницу категорий, выполняет те же функции. Но Disallow: /category/*/* более наглядно что ли =) А так разницы нет

Спасибо, с этим все понятно.

Еще немного нубский вопрос.

Хочу удалить на сайте архив по месяцам, полностью. Убираю виджет соответствующий в админке, но по url архивы остаются доступны.

Можно ли их удалить как-то через админку, чтоб выдавало ошибку 404?

Да архивы можно отключить, через код в function.php

add_filter( 'request', 'disable_datetime_queries' );/**

* Проверяет, содержится ли в URL требование получить архив постов по датам. Если так, то вместо этого архива будет выводиться страница 404.

*

* Функция навешивается на фильтр-хук 'request'

*/

function disable_datetime_queries( $args )

{

foreach ( array('second', 'minute', 'hour', 'day', 'monthnum', 'year', 'w', 'm') as $key)

{

if ( array_key_exists($key, $args) AND isset($args[$key]) )

{

return array( 'error' => '404' );

}

}

return $args;

}

У меня есть файл functions.php в моей теме.

Нужно вставить этот код туда?

да, вставлять между < ?php и ?>

Спасибо!

Еще вопрос по теме robots.txt

Надо ли закрывать пагинацию страниц самих записей блога и как это сделать?

Таким образом:

Disallow: /page

Или еще каким?

Да, так можно закрыть пагинацию записей на главной. А надо ли — вопрос. Если у вас с индексацией порядок, настроена карта сайта — как обычная так и xml, если идут твиты ретвиты и т.д. то можно закрыть.

Да нет, пока вообще мало что есть. Просто не хочется, чтоб всякая ненужная ерунда в индекс лезла. Я пока изучаю вопрос.

Валидатор файлов Sitemap мне ответил. Файл Sitemap не должен быть главной страницей сайта.А где его поставить не знаю,я пока ещё даже и не чайник,а на много хуже.Подскажите пжалуйста. 😥

Сергей, добрый день! Такой вопрос, если я категории, т.е. рубрики выношу в меню сайта в таком случае мне необходимо убрать из robots.txt строки Disallow: /category и отразится ли каким-то образом на СЕО-продвижении сайта? Спасибо!)

Добрый день. Только если вы хотите, что бы поисковик находил в поиске эти самые страницы рубрик. Если же там ничего ценного нет кроме дублей (в большинстве случаев так и есть) то смело закрывайте